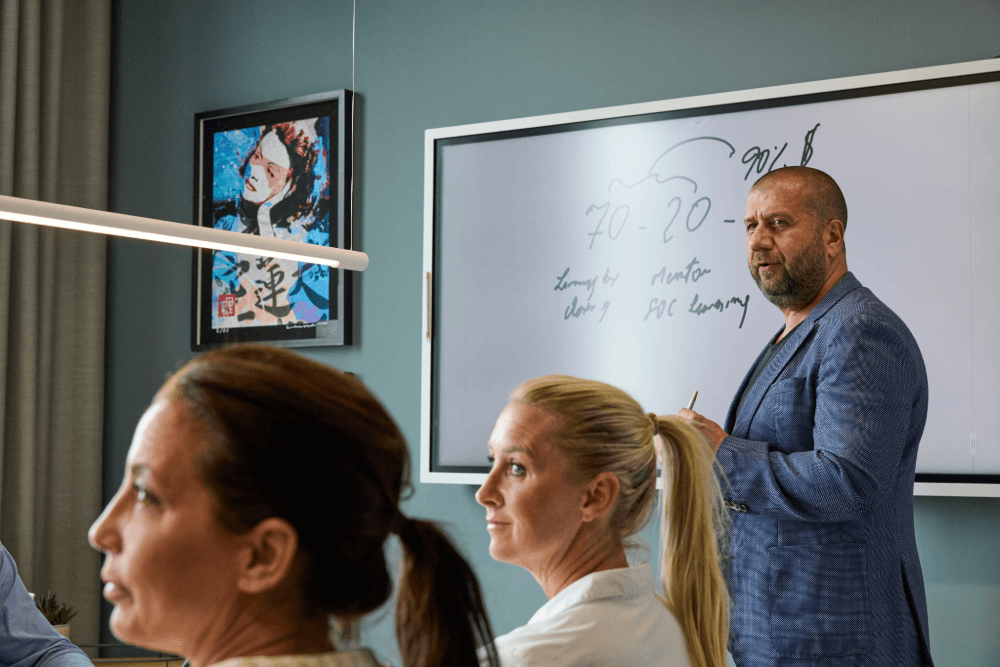

Utbildningar

Din utveckling är vår passion. Oavsett om du vill stärka din egen kompetens eller ta din organisation till nästa nivå, finns vi här som en strategisk utbildningspartner. Tillsammans skapar vi möjligheter att växa och möta morgondagens utmaningar.

Våra utbildningsområden

Vill du ha en mer produktiv vardag? Vi hjälper dig att utveckla och effektivisera ditt arbetsliv.

Utveckla dig själv, dina medarbetare och din verksamhet. Vi har utbildningar för både nya och erfarna chefer och ledare.

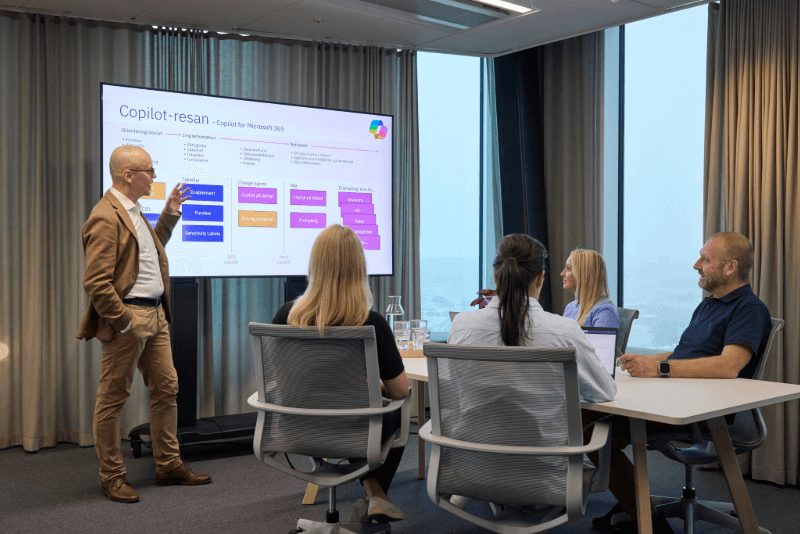

Kurser inom programmering, nätverk, databaser och cybersäkerhet – utveckla din IT-expertis med oss

Oavsett om du vill bredda din kompetens, certifiera dig eller fördjupa dina kunskaper inom ett specifikt område har vi kurserna för dig.

Kompetenskort

Säkerställ bästa tänkbara ekonomiska lösning och att ni har budget när utbildningsbehovet kommer, via Cornerstones kompetenskort. Kompetenskortet laddar ni med ett antal utbildningsdagar vilket ger flexibilitet såväl som bra priser och enkelhet i administrationen.

Vad passar dig bäst?

Relaterat innehåll